Entrada hecha por un humano, en concreto, por Daniel Amo-Filva.

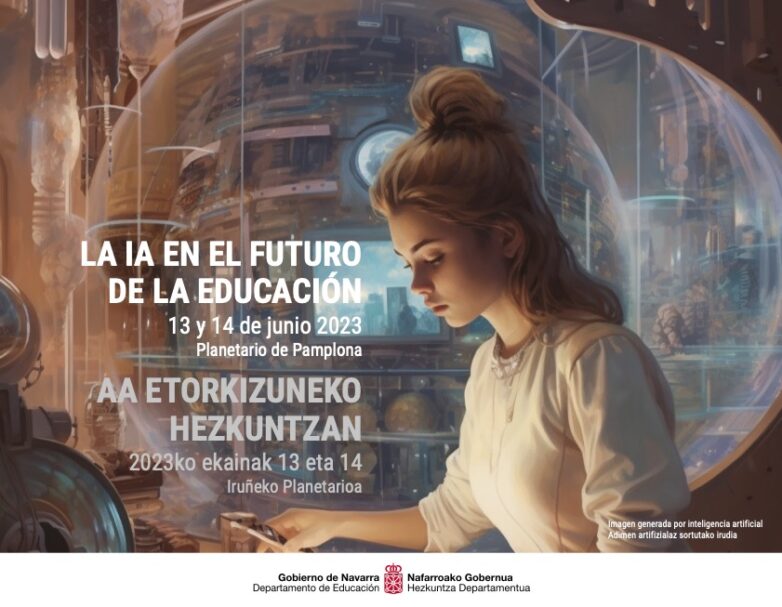

Hoy he participado en las jornadas La IA en el futuro de la educación, realizadas en Pamplona y organizadas por el Gobierno de Navarra, al que estoy enteramente agradecido por la oportunidad de compartir. He hablado sobre Inteligencia Artificial generativa (IAG) y análisis de datos en educación. En concreto, compartí la idea de que los docentes no requieren de una elevada alfabetización de datos. El motivo: los modelos de lenguaje de gran escala (LLM). Estos modelos se basan en la arquitectura Transformer creada por Google en el 2017, y que ahora está en todas las aplicaciones tecnológicas que se nos pueda ocurrir. Es decir, se está tratando de resolver todo problema mediante tecnología de modelos de lenguaje; y los resultados son mejoría en todos los sentidos.

Los transformadores pre-entrenados generativos (GPT, Generative Pre-trained Transformer) son fruto de una doble evolución. Por una parte, el hardware que ha hecho capaz la computación matemática que subyace en las técnicas de IA. Por otra parte, el software en cuanto a algoritmos matemáticos de Machine Learning y Deep Learning. Los GPT son modelos que predicen qué siguiente palabra es la que va a continuación de la frase en construcción. Las GPU y TPU, que permiten realizar cálculos matemáticos con matrices y a gran velocidad, han dado un fuerte empujón a estos modelos de IA y ahora estamos de alguna manera recogiendo los frutos. No obstante, me pregunto si estos frutos están envenenados.

Esta tecnología de predicción de palabras lo ha puesto todo de patas arriba. En educación, es capaz de generar contenidos personalizados, rúbricas de evaluación, enunciados de ejercicios y exámenes, emular personajes históricos, escribir un correo electrónicos a los padres e incluso evaluar ensayos de los estudiantes; y además con una calidad excepcional. Su capacidad de generación de texto en distintos aspectos de la educación nos ha sorprendido, seducido y deslumbrado. Y, como siempre, tonto el último quien no lo utilice. Pero, y a pesar de sus más que demostradas capacidades generativas, tras escuchar las charlas de mis compañeros en las jornadas de la IA, compartir inquietudes con los participantes y cruzar conversaciones con distintos miembros de la organización, no ha dejado de rondarme e inquietarme la siguiente pregunta: ¿Es ChatGPT necesario en la docencia? Cuidado que no digo en el aprendizaje, me refiero en las acciones docentes relacionados con docencia.

La principal inquietud compartida por los docentes de distintos territorios con los que he tenido la suerte de comentar toda esta movida del ChatGPT (y otros modelos) coinciden en una misma pregunta, ¿y ahora qué tenemos que hacer? No tengo respuesta definitiva ante tal pregunta, sino otras más preguntas que abren más preguntas. A todo ello, me pregunto si realmente, como docentes, tenemos que hacer uso de esta tecnología. No pongo en duda las capacidades de los chatbots como herramientas educativas, ni por asomo la ayuda que este tipo de modelos lingüísticos proporcionan a los estudiantes. Pero como docentes, ¿en qué nos ayuda?

Durante mi ponencia en la jornada de Pamplona he expuesto lo que creo que sucederá con la alfabetización de datos en educación. Escribí una entrada de ello, y me reafirmo en que hará la analítica del aprendizaje transparente en los procesos de enseñanza-aprendizaje. No será necesaria una alfabetización de datos de alto nivel y solo se requerirá una capacidad interpretativa de texto y mínima matemática en cuestión de interpretación de porcentajes y métricas básicas. Un docente excelente no requiere ser un científico de datos, la docencia no va de esto. Y precisamente esta idea destruye la analítica del aprendizaje.

Llevo mucho tiempo queriendo destruir la analítica del aprendizaje. Destruirla tal como la conocemos y erradicarla de la forma que la practicamos. Desde el 2015, cuando empecé a divulgar sobre analítica del aprendizaje, que me queda un sabor agridulce tras cada charla. Hoy en las jornadas IA Pamplonicas, he sentido por primera vez que no hablaba de ciencia ficción en educación. Durante todos estos años he podido transmitir las oportunidades y riesgos de analizar datos educativos, de cómo realizarlo y qué se requiere para hacerlo. Pero nunca me había sentido tan cerca de los docentes. Por primera vez he visto atisbos de democratizar la analítica del aprendizaje.

La alfabetización de datos es una barrera para la adopción y uso de la analítica del aprendizaje. Es una barrera casi infranqueable para cualquier docente. Comprender e interpretar resultados analíticos es muy distinto a tratar y transformar datos analíticamente, hay un abismo entre una cosa y la otra. Son dos caras de la misma moneda; ahora la segunda ya no es necesaria aprenderla. De hecho, y he vivido equivocado durante todos estos años, los docentes nunca han tenido que saber análisis de datos. Como ahora tampoco requieren saber cómo funcionan los Transformers para usarlos en sus aulas, pero sí conocer sus limitaciones, sus riesgos y sus oportunidades educativas.

Quizás he llegado a estas conclusiones puesto que me doy cuenta de las posibilidades de automatización que estos modelos lingüísticos ofrecen en el análisis de datos educativos. Por este motivo justifico la destrucción de la analítica del aprendizaje en cuanto a que pasa a convertirse en un proceso invisible, transparente y de fácil ejecución. Con los modelos de lenguaje a gran escala conectados a plugins (o usando funciones que llaman a APIs de terceros) que realizan el cómputo de datos, cualquier docente puede pedirles en lenguaje natural y nada técnico que realicen análisis a conveniencia. Entramos en una nueva manera de hacer analítica del aprendizaje ¡Viva la destrucción de la analítica del aprendizaje!